一、硬件准备

准备台电脑,需要 windows 10 以上的系统,磁盘剩余可用10G以上(根据选用模型大小,最少需要5G),配置越高越好,尤其是显卡,至少要是独显 4G 以上,越大越好

二、安装Ollama

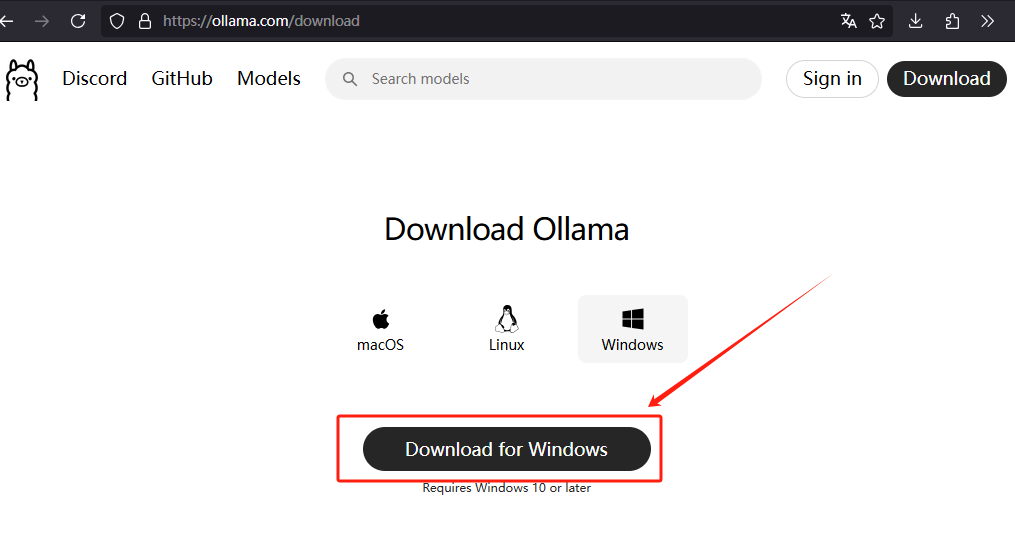

访问Ollama下载页:ollama.com/download

下载完后双击安装,安装结束即可。

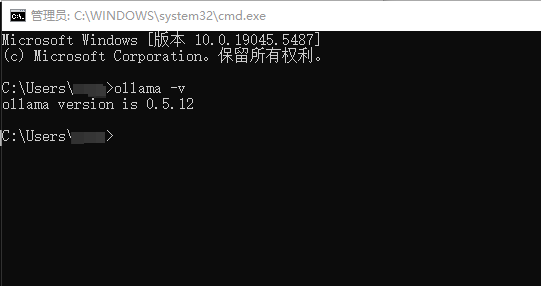

安装完成后,在终端里面(WIN+R,输入cmd)运行

ollama -v查看版本信息,显示正常就表示安装成功。

三、下载模型

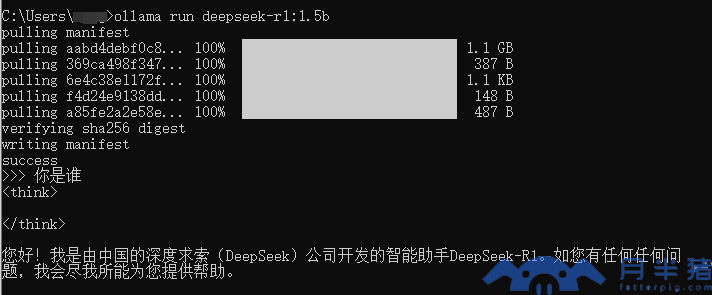

1、在终端(WIN+R,输入cmd)输入:

ollama run deepseek-r1:1.5b最后的一点下载会比较慢,需要耐心等待。命令执行完成后,出现 “SUCCESS” 字样,就可以直接对话了。

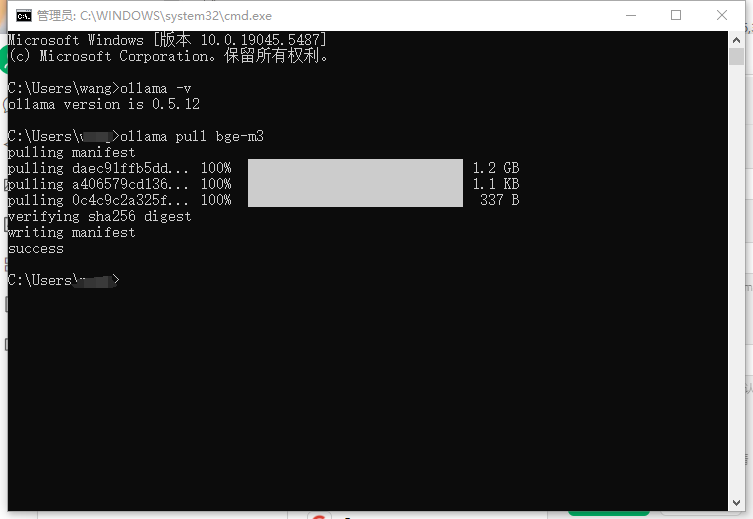

2、搭建个人知识库需要搭配嵌入式模型,将文本转换为高维向量,以便用于检索、相似度计算等任务。

ollama pull bge-m3

命令执行完成后,出现 “SUCCESS” 字样代表下载完成

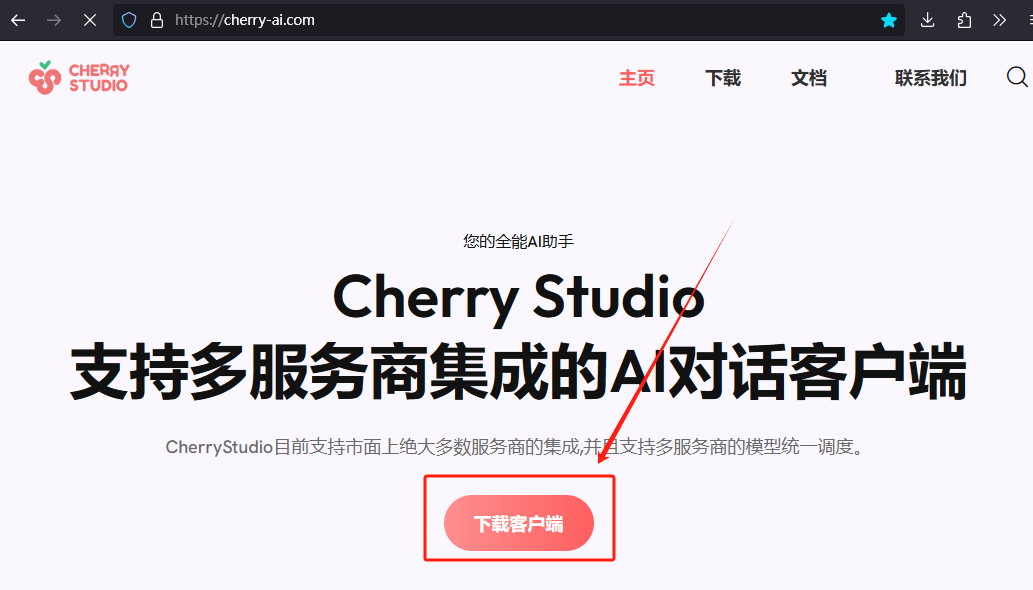

四、安装Cherry Studio

访问Cherry-AI主页:cherry-ai.com

下载完成后,双击程序直接默认安装即可。

五、添加模型服务

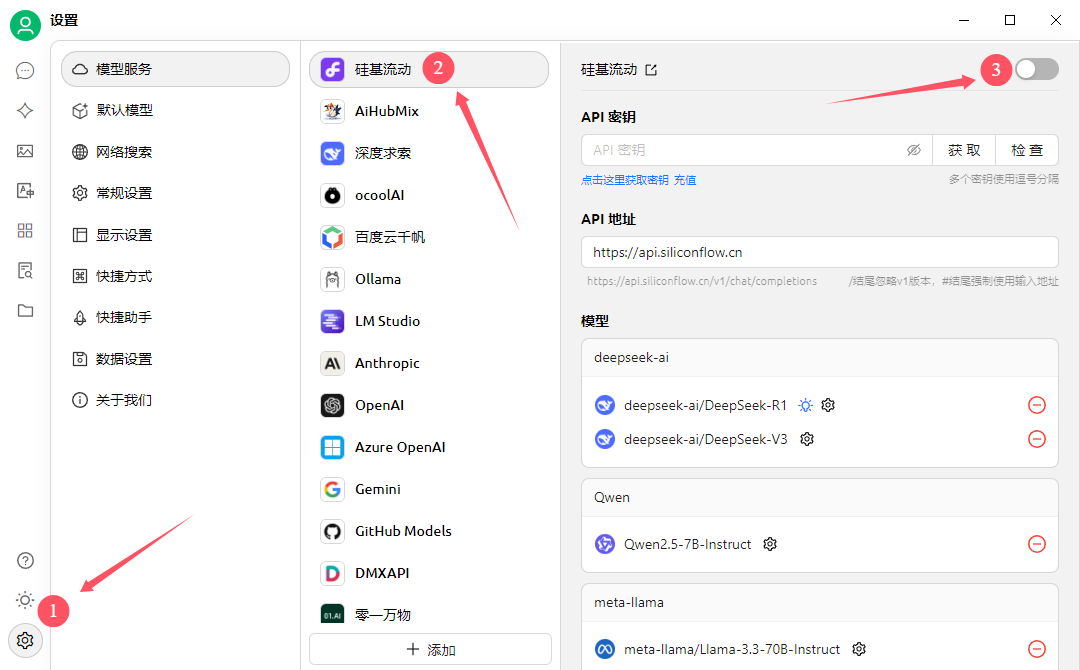

1. 配置模型

在第三步中已经 run deepseek-r1,也下载了 bge-m3 ,现在打开 Cherry Studio 添加模型服务。

关闭自带的硅基流动

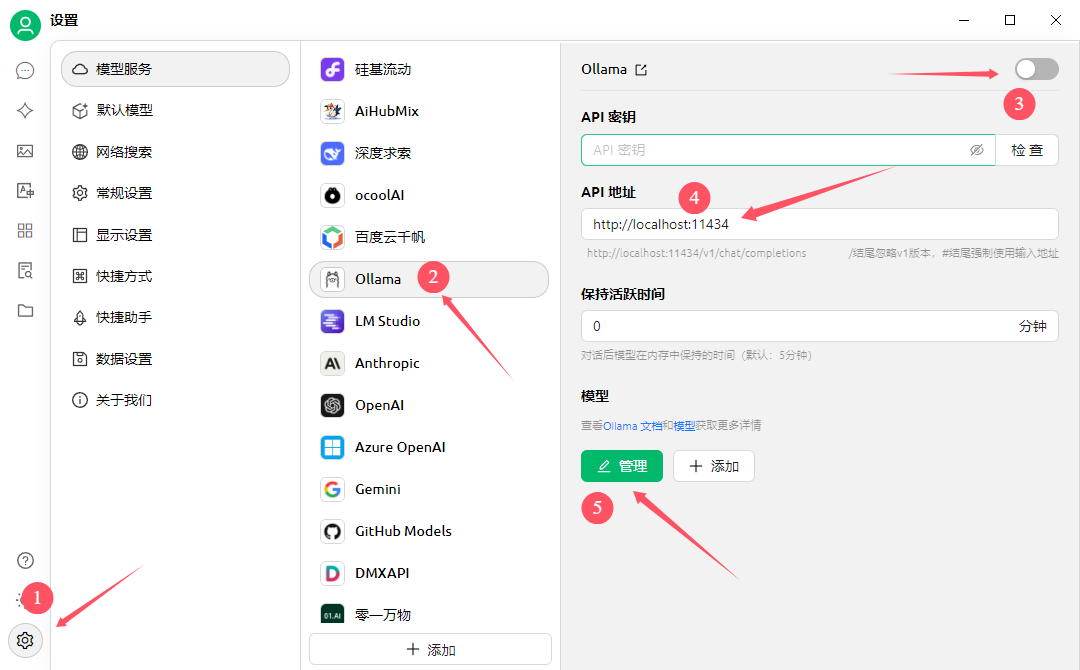

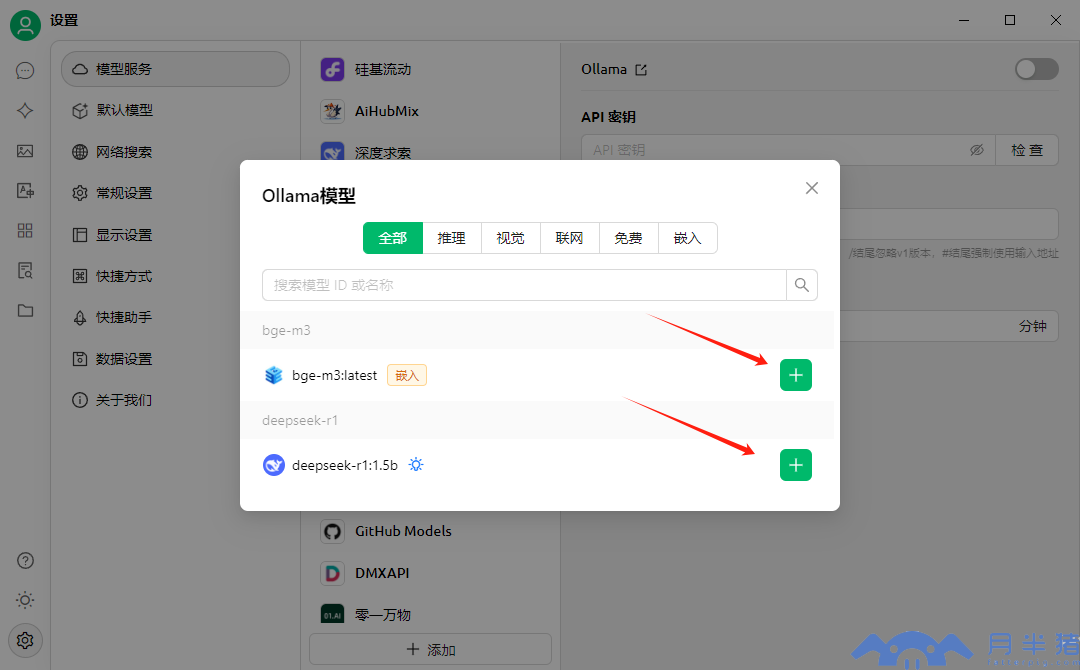

2. 添加模型

六、 配置本地知识库

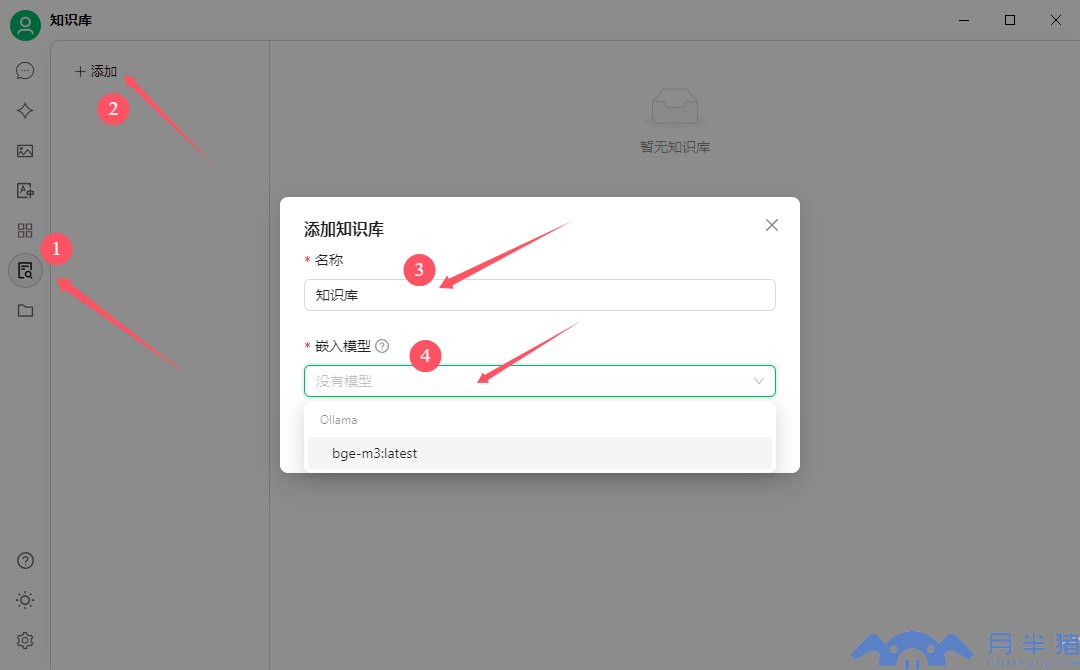

1. 进入到知识库页面中区,添加不同主题的知识库

2. 上传本地知识文档

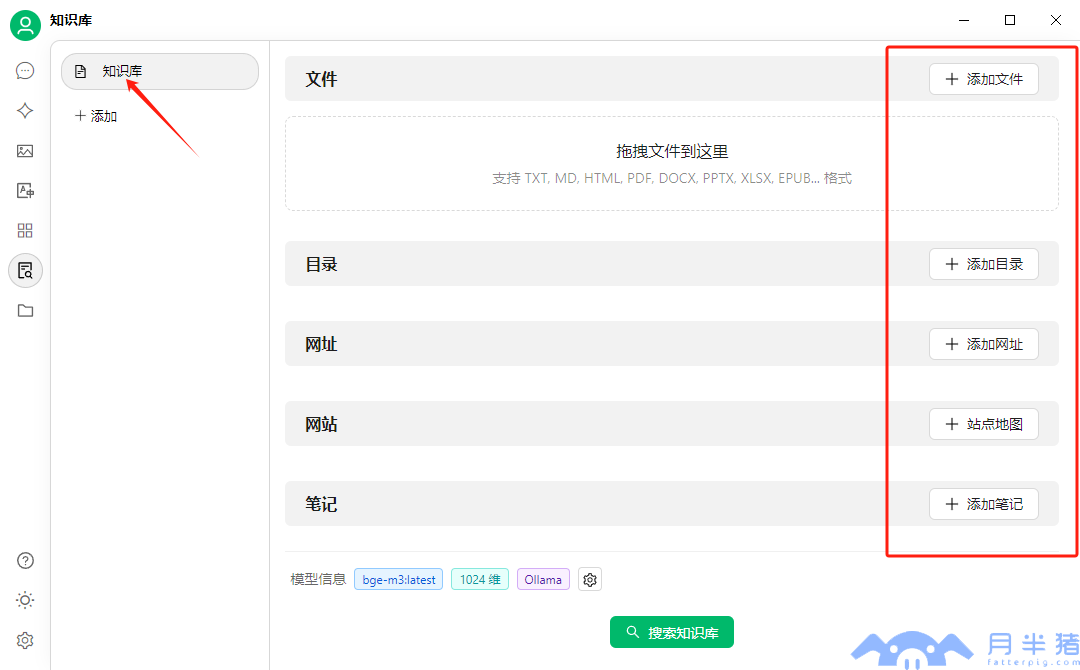

进入到知识库页面中区,添加不同主题的知识库,这个自己去组织,然后在右边添加文件、目录、网址、网站、笔记等知识

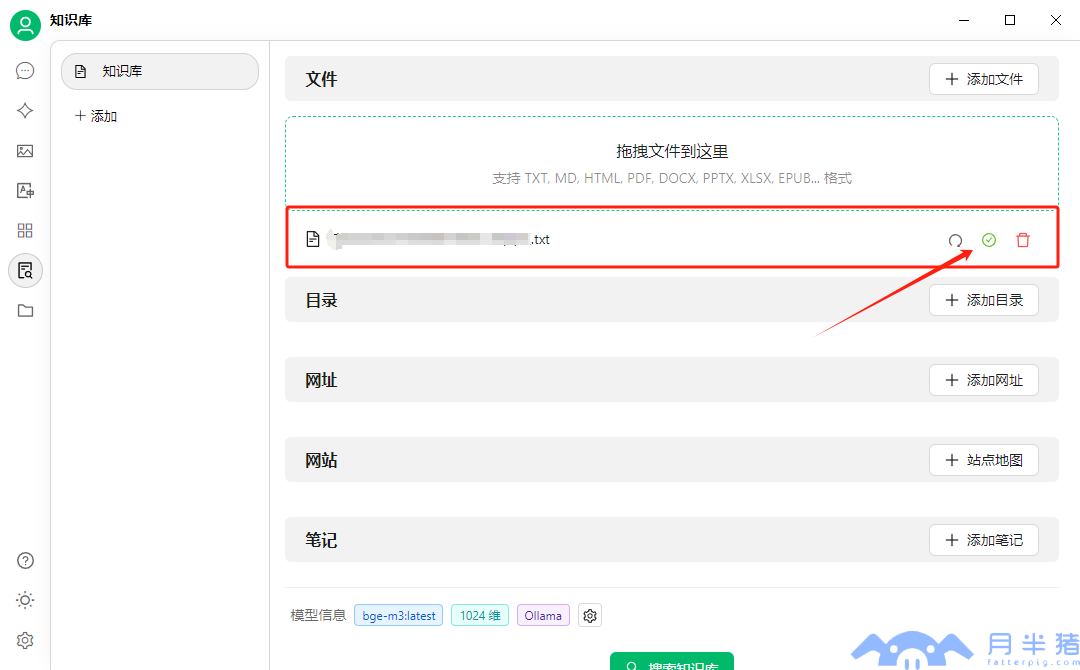

等待一段时间以后,文件边上出现了绿色的勾勾,说明已经解析完成了(这个过程会比较久)。

七、 开始使用

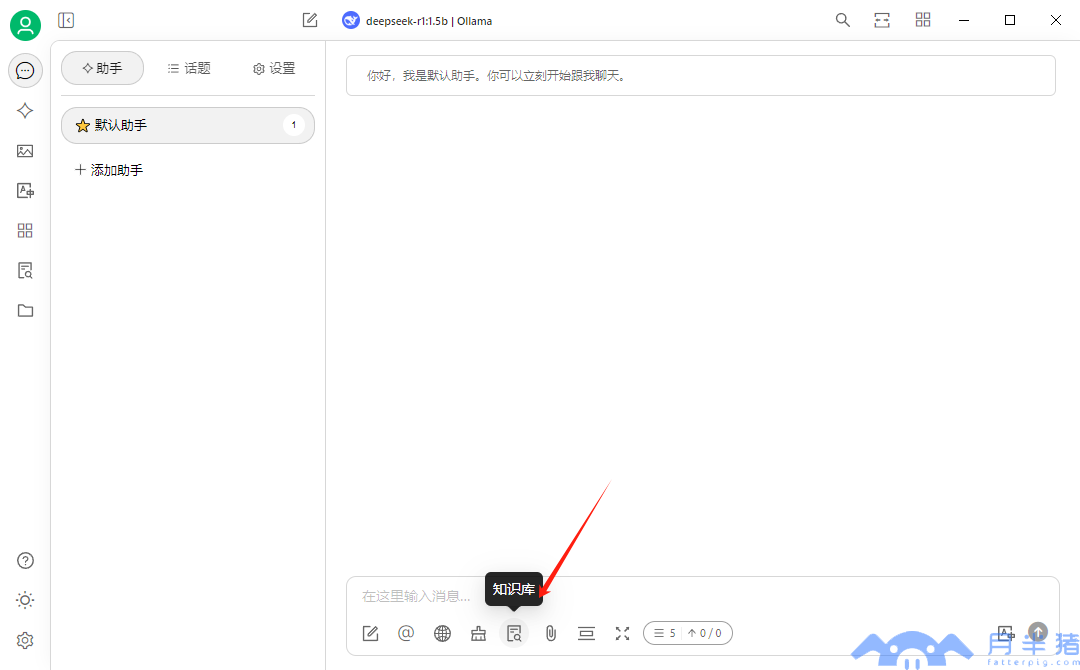

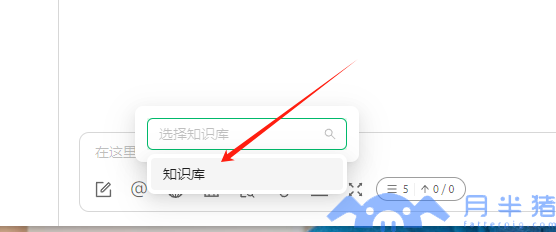

- 选取知识库

- 开始正常使用

八、总结

由于硬件限制,本地部署性能不如直接使用云服务,本次作为记录搭建过程的笔记,所以选取的是蒸馏版模型,如果硬件足够好可以选择 70 b 或者 671b 使用,问题的思考时间会有明显的缩短,AI幻觉会得到明显的减少。